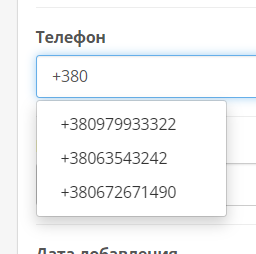

Вебмастер, robots.txt

-

Схожі публікації

-

- 8 відповідей

- 3 091 перегляд

-

Google не индексирует страницы из-за запрета в robots.txt (где убрать запрет)

Автор: Exer,

- robots.txt

- robots.txt гугл

- (і ще %d)

- 2 відповіді

- 532 перегляди

-

- 0 відповідей

- 621 перегляд

-

- 2 відповіді

- 793 перегляди

-

- 5 відповідей

- 823 перегляди

-

-

Зараз на сторінці 0 користувачів

- Ні користувачів, які переглядиють цю сторінку

Recommended Posts

Створіть аккаунт або увійдіть для коментування

Ви повинні бути користувачем, щоб залишити коментар

Створити обліковий запис

Зареєструйтеся для отримання облікового запису. Це просто!

Зареєструвати аккаунтВхід

Уже зареєстровані? Увійдіть тут.

Вхід зараз